Artificiële intelligentie (AI) heeft zich snel ontwikkeld tot het punt waarop het een integrale rol speelt in tal van sectoren, van gezondheidszorg tot financiën en nog meer. De grondslag van het succes van AI is het vermogen om enorme gegevenssets te verwerken op een manier die betrouwbare resultaten oplevert.

Het is een gegeven dat succesvolle bedrijven AI willen gebruiken of er al mee werken. Maar ze richten zich niet alleen op het implementeren van AI. Ze streven naar betrouwbare AI-modellen, -processen en -resultaten. Ze hebben AI nodig die ze kunnen vertrouwen.

Een van de cruciale processen die de ontwikkeling van AI-modellen mogelijk maken, is het inlassen van controlepunten (checkpointing). In deze wegwijzer lichten we toe wat checkpointing is, hoe het in AI-werkbelastingen past en waarom het essentieel is voor het creëren van betrouwbare AI (d.w.z. AI-gegevensworkflows die betrouwbare inputs gebruiken en betrouwbare inzichten genereren).

Wat is checkpointing?

Checkpointing is het proces waarbij de toestand van een AI-model wordt opgeslagen op specifieke, korte intervallen tijdens de training van dat model. AI-modellen worden getraind op basis van grote gegevenssets door middel van iteratieve processen die minuten tot maanden kunnen duren. De duur van de training van een model hangt af van de complexiteit van het model, de grootte van de gegevensset en de beschikbare rekenkracht. Tijdens die training worden modellen gevoed met gegevens, worden parameters aangepast en leert het systeem hoe het resultaten kan voorspellen op basis van de informatie die het verwerkt.

Controlepunten fungeren als momentopnames van de actuele toestand van het model (de gegevens, parameters en instellingen ervan), op vele punten tijdens de training. Aan de hand van die momentopnames, die elke minuut of om de paar minuten op opslagapparaten worden opgeslagen, kunnen ontwikkelaars de voortgang van het model bijhouden en voorkomen dat waardevol werk verloren gaat bij onverwachte onderbrekingen.

Belangrijkste voordelen van checkpointing.

- Stroombeveiliging. Een van de meest directe en praktische voordelen van checkpointing is het beschermen van trainingstaken tegen systeemstoringen, stroomuitval of crashes. Als een AI-model al dagen draait en het systeem door een storing wordt getroffen, zou het een enorme verspilling van tijd en middelen zijn om helemaal opnieuw te beginnen. Controlepunten zorgen ervoor dat het model verder kan gaan vanaf de laatst opgeslagen toestand, zodat de training niet vanaf het begin hoeft te worden herhaald. Dit is vooral van groot belang voor AI-modellen waarvan de training weken of zelfs maanden duurt.

- Modelverbetering en -optimalisering. Checkpointing biedt niet alleen bescherming tegen storingen, maar biedt ook mogelijkheden voor fijnafstelling en optimalisering. AI-ontwikkelaars experimenteren vaak met verschillende parameters, gegevenssets en configuraties om de nauwkeurigheid en efficiëntie van het model te verbeteren. Door tijdens het trainingsproces controlepunten op te slaan, kunnen ontwikkelaars eerdere toestanden analyseren, de voortgang van het model volgen en parameters aanpassen om de training in een andere richting te sturen. Ze kunnen de instellingen van grafische verwerkingseenheden (GPU's) aanpassen, gegevensinput wijzigen of de modelarchitectuur veranderen. Controlepunten bieden een manier om verschillende runs te vergelijken en vast te stellen waar wijzigingen de prestaties verbeteren of verslechteren. Zo kunnen ontwikkelaars AI-training optimaliseren en robuustere modellen maken.

- Wettelijke naleving en bescherming van intellectuele eigendom. Naarmate de AI-regelgeving zich wereldwijd ontwikkelt, moeten organisaties steeds vaker bijhouden hoe AI-modellen worden getraind om aan wettelijke kaders te voldoen en de bescherming van intellectuele eigendom (IE) te waarborgen. Met checkpointing kunnen bedrijven naleving aantonen door een transparant verslag te verstrekken van de gegevens en methodologieën die gebruikt zijn om hun modellen te trainen. Dit beschermt u tegen juridische uitdagingen en zorgt ervoor dat het trainingsproces kan worden gecontroleerd, mocht dat nodig zijn. Bovendien beschermt het opslaan van controlepuntgegevens de IE die betrokken is bij de modeltraining, zoals bedrijfseigen gegevenssets of algoritmen.

- Vertrouwen opbouwen en transparantie garanderen. Het belang van transparantie in AI-systemen kan niet genoeg worden benadrukt, vooral omdat AI steeds verder wordt geïntegreerd in besluitvormingsprocessen in sectoren zoals de gezondheidszorg en de financiële sector, alsook in autonome voertuigen. Een van de sleutels tot het bouwen van betrouwbare AI is ervoor zorgen dat de beslissingen van het model verklaard en herleid kunnen worden naar specifieke gegevensinputs en verwerkingsstappen. Checkpointing draagt bij aan deze transparantie door de toestand van het model in elke trainingsfase bij te houden. Met deze opgeslagen toestanden kunnen ontwikkelaars en belanghebbenden het verloop van het model volgen, controleren of de output consistent is met de gegevens waarop deze is getraind, en ervoor zorgen dat er verantwoording kan worden afgelegd over de manier waarop beslissingen worden genomen.

Naarmate AI-toepassingen zich uitbreiden tot buiten de traditionele datacenters, hebben ze steeds meer behoefte aan hoge opslagcapaciteit en hoge prestaties. Of het nu in de cloud of on-premises is, AI-workflows vertrouwen op opslagoplossingen die zowel een enorme opslagcapaciteit als krachtige prestaties bieden, die beide essentieel zijn voor checkpointing.

In AI-datacenters worden processors, zoals GPU's, centrale verwerkingseenheden (CPU's) en tensorverwerkingseenheden (TPU's) nauw gekoppeld aan krachtig geheugen en solid-state-schijven (SSD's) om krachtige rekenengines te vormen. Deze configuraties beheren de zware gegevensbelasting die gepaard gaat met training, en bieden de snelle toegang die nodig is om controlepunten in real time op te slaan naarmate de modellen vorderen.

Terwijl gegevens door deze systemen stromen, worden controlepunten en andere kritieke informatie bewaard in netwerkopslagclusters of objectopslag. Deze clusters zijn voornamelijk gebouwd op basis van harde schijven met een grote opslagcapaciteit, en zorgen ervoor dat controlepunten langdurig bewaard kunnen blijven, om te voldoen aan de vereisten van schaalbaarheid en regelnaleving. Deze gelaagde opslaginfrastructuur zorgt ervoor dat checkpointing efficiënt werkt, waarbij snelle toegang en langdurig behoud van gegevens in balans zijn.

Hoe checkpointing in de praktijk werkt.

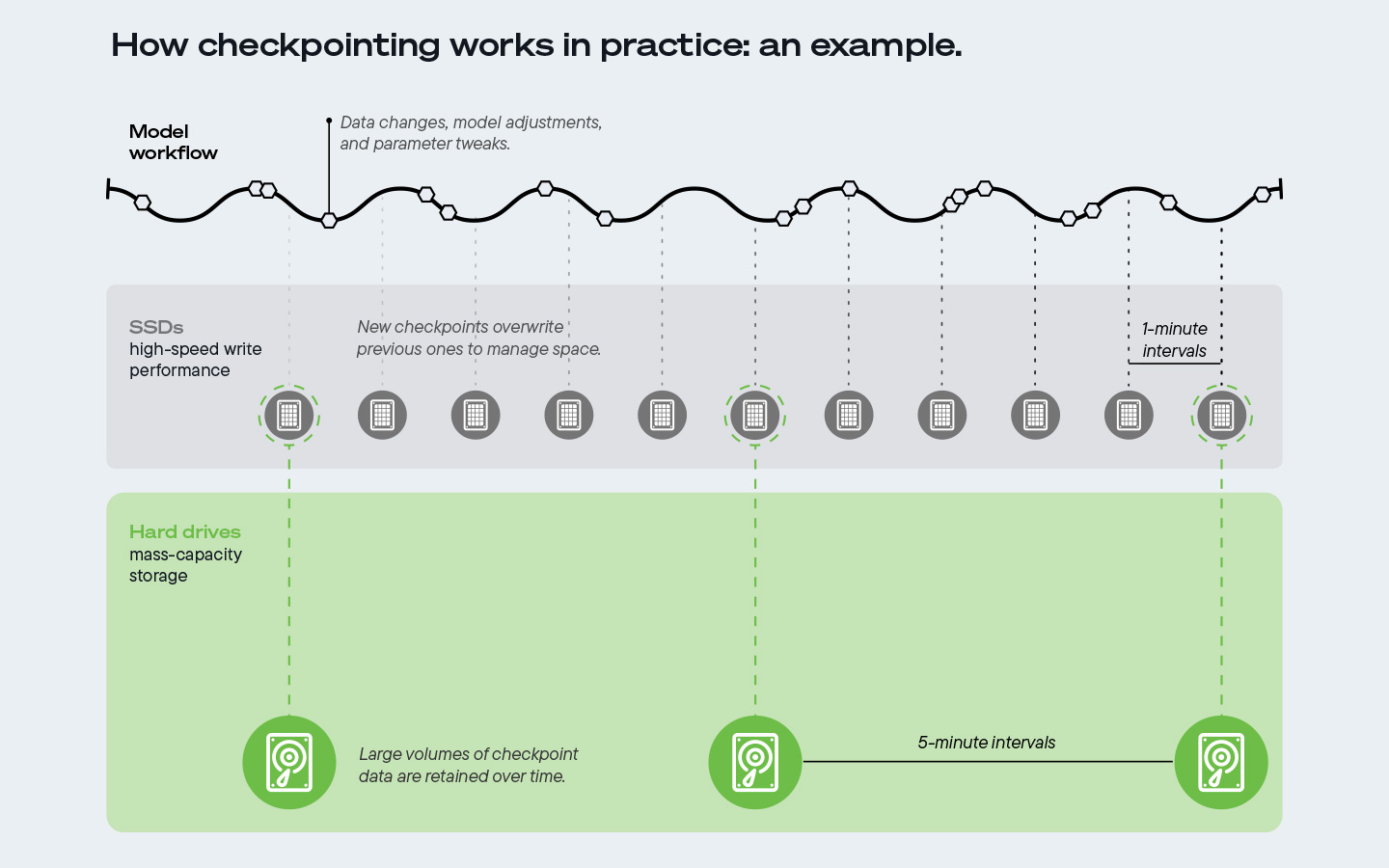

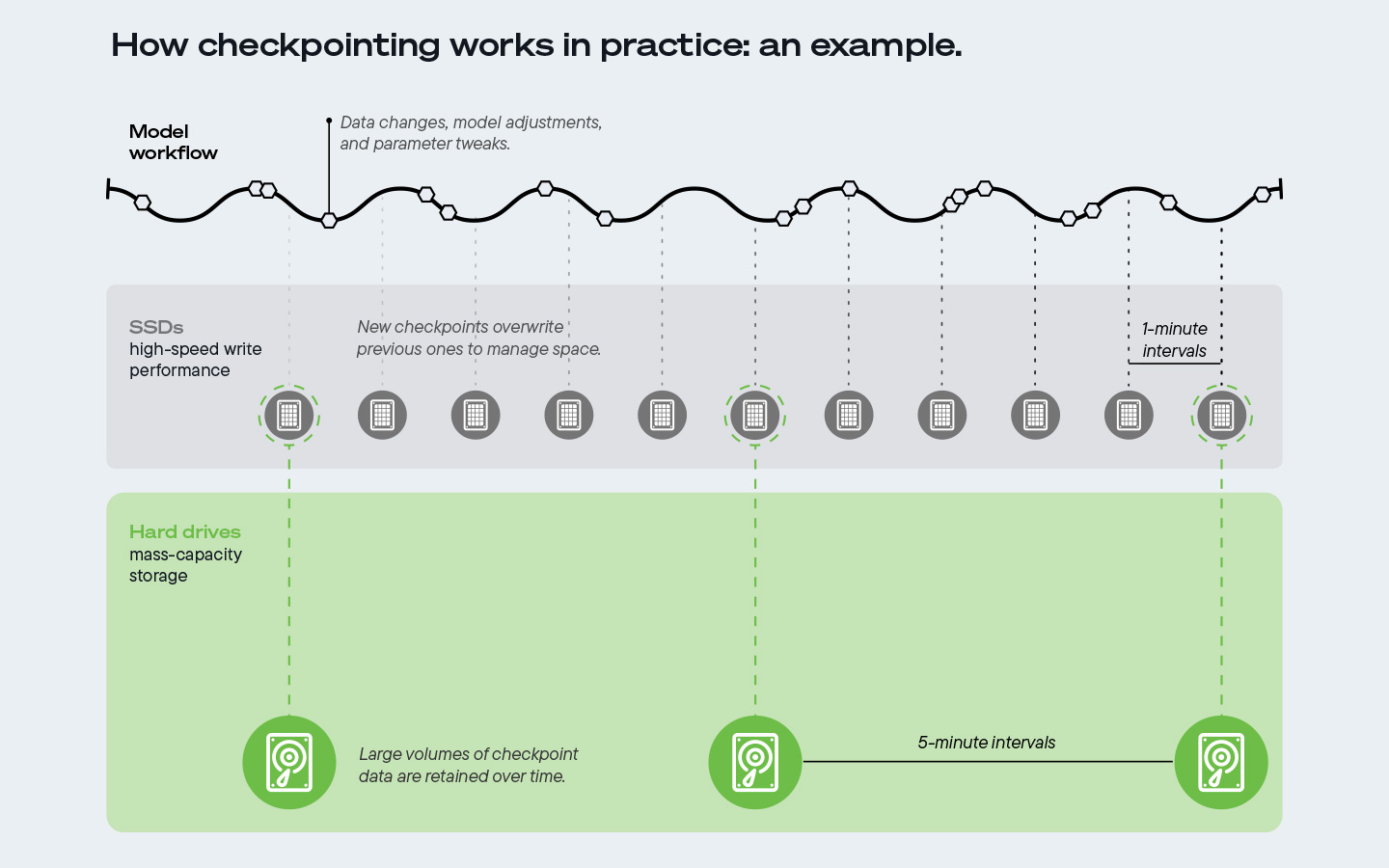

Checkpointing gebeurt meestal met regelmatige tussenpozen (van elke minuut tot om de paar minuten), afhankelijk van de complexiteit en de behoeften van de trainingstaak.

Het is een gangbare praktijk om ongeveer elke minuut controlepunten te schrijven naar SSD's, die supersnelle schrijfprestaties bieden, waardoor snelle gegevenstoegang mogelijk is tijdens een actieve training. Omdat SSD's niet rendabel zijn voor massale opslag op lange termijn, overschrijven nieuwe controlepunten de vorige om ruimte te besparen.

Aangezien AI-trainingen vaak enorme hoeveelheden gegevens genereren over langere perioden, is opslagcapaciteit essentieel. AI-ontwikkelaars slaan bijvoorbeeld ongeveer elke vijf minuten controlepunten op harde schijven op. Die harde schijven zijn van kritiek belang om grote hoeveelheden controlepuntgegevens in de loop van de tijd bij te houden. Met een kosten-per-TB-verhouding van gemiddeld meer dan 6:1 in vergelijking met SSD's, bieden harde schijven de meest schaalbare, voordelige oplossing en zijn ze de enige praktische optie voor de grootschalige gegevensopslag die nodig is om ervoor te zorgen dat AI betrouwbaar is.

In tegenstelling tot SSD's die bij frequente schrijfcycli erop achteruitgaan door de slijtage van de flashgeheugencellen, maken harde schijven bovendien gebruik van magnetische opslag die continu gebruik kan verdragen zonder aan integriteit in te leveren. Dankzij deze duurzaamheid kunnen harde schijven de betrouwbaarheid van gegevens op de lange termijn handhaven, waardoor organisaties controlepunten voor onbepaalde tijd kunnen bewaren en eerdere trainingsruns opnieuw kunnen bekijken en analyseren lang nadat het model is ingezet, ter ondersteuning van robuuste AI-ontwikkeling en behoeften aan regelnaleving.

De oneindige AI-gegevenslus en de rol ervan in AI-workflows.

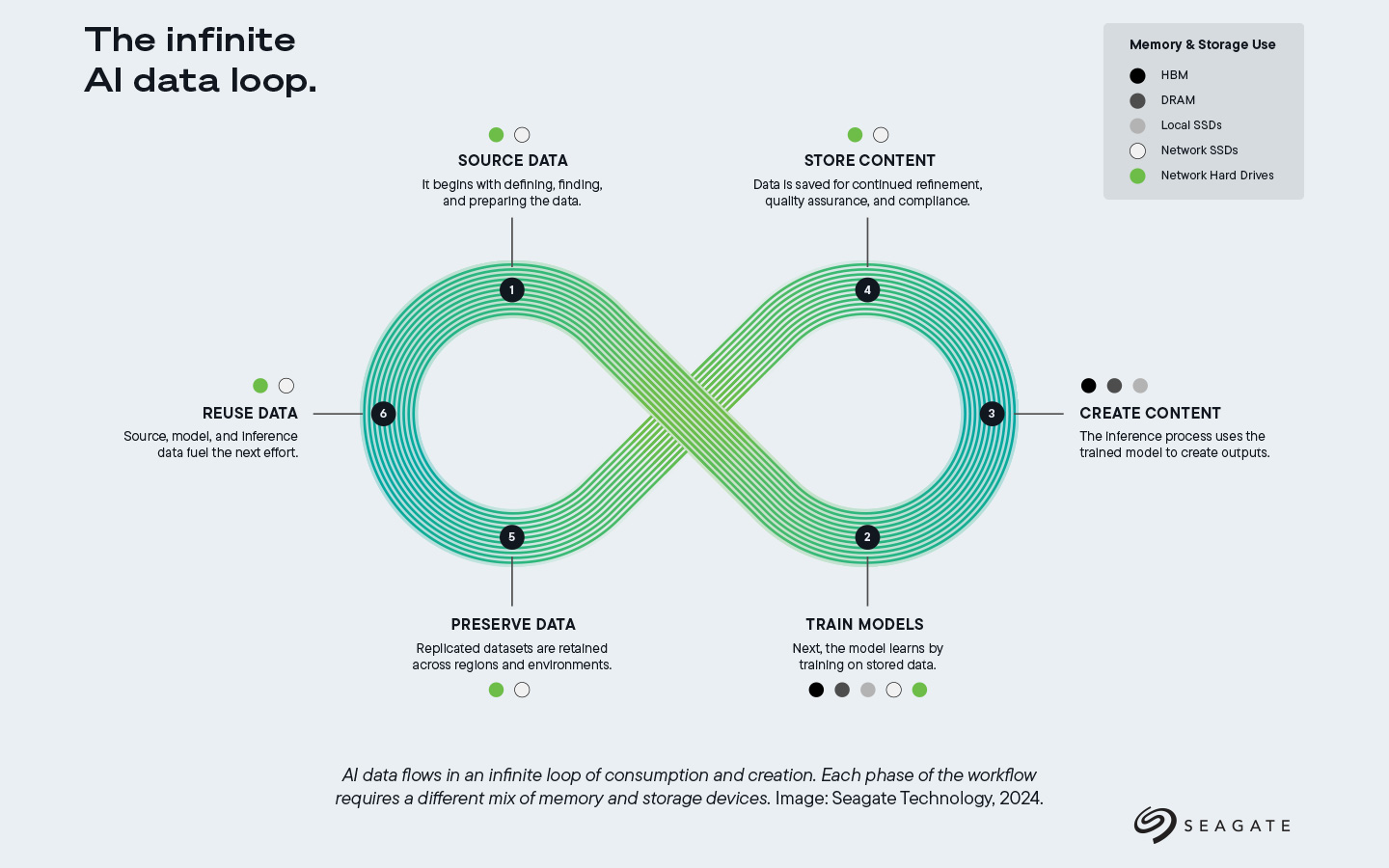

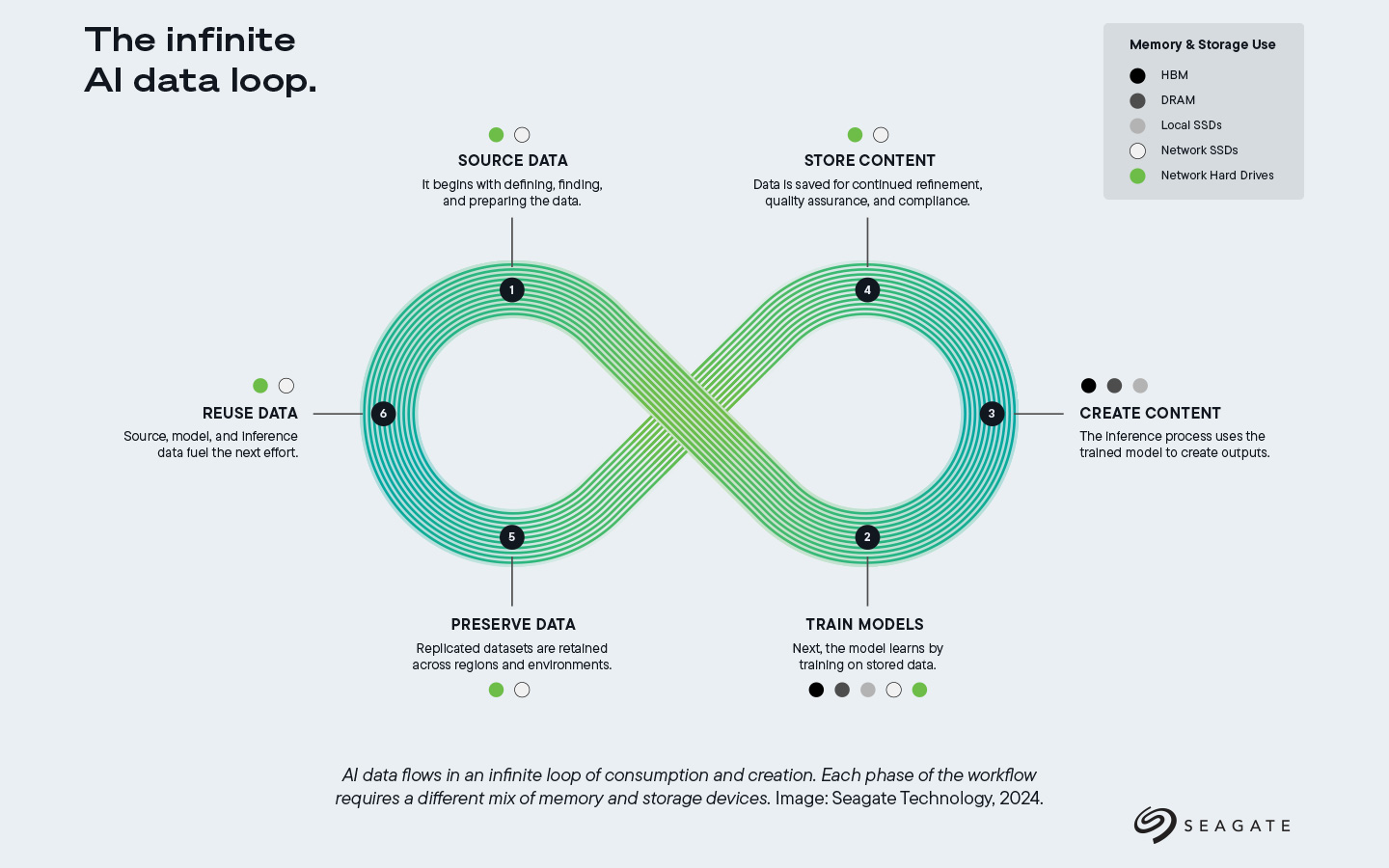

AI-ontwikkeling kan worden opgevat als een cyclisch proces dat vaak de oneindige AI-lus wordt genoemd. Deze lus benadrukt de voortdurende interactie tussen de verschillende stadia van gegevensverzameling, modeltraining, creatie en opslag van content, en behoud en hergebruik van gegevens. Deze cyclus zorgt ervoor dat AI-systemen in de loop van de tijd iteratief verbeteren. In deze lus worden AI-modellen gevoed door gegevens en de output van de ene fase wordt input voor de volgende fasen, wat leidt tot een voortdurende, iteratieve verfijning van de modellen.

Het proces begint met brongegevens, waarbij sets van onbewerkte gegevens worden verzameld en voorbereid voor een training. Zodra de gegevens zijn verzameld, worden ze gebruikt om modellen te trainen, en dat is waar checkpointing om de hoek komt kijken. Zoals eerder is beschreven, dient checkpointing als een beveiliging tijdens modeltraining, zodat AI-ontwikkelaars hun voortgang kunnen opslaan, geen werk verliezen door onderbrekingen, en de modelontwikkeling kunnen optimaliseren. Nadat de modellen zijn getraind, worden ze gebruikt om content te creëren, bijvoorbeeld voor het uitvoeren van inferentietaken zoals het genereren van afbeeldingen of het analyseren van tekst. Deze outputs worden dan opgeslagen voor toekomstig gebruik, regelnaleving en kwaliteitscontrole, voordat de gegevens uiteindelijk worden bewaard en hergebruikt als brandstof voor de volgende iteratie van het AI-model.

In deze oneindige lus is checkpointing een essentieel element, met name in de trainingsfase van het model. Door modeltoestanden op te slaan en gegevens door de lus heen te bewaren, kunnen AI-systemen bij elke cyclus degelijker, transparanter en betrouwbaarder worden.

Waarom harde schijven essentieel zijn voor AI-checkpointing.

De opslagvereisten van AI-systemen zijn enorm en naarmate modellen groter en complexer worden, groeit de behoefte aan schaalbare, voordelige opslag. Harde schijven, vooral in datacenterarchitecturen, vormen om verschillende redenen de ruggengraat van de opslag van AI-controlepunten:

- Schaalbaarheid. AI-modellen kunnen petabytes aan gegevens genereren, en dankzij de baanbrekende vooruitgang op het gebied van oppervlaktedichtheid bieden harde schijven de nodige capaciteit om controlepunten van deze grootschalige trainingstaken op lange termijn op te slaan.

- Kostenefficiëntie. Vergeleken met SSD's zijn harde schijven veel goedkoper per terabyte (in een verhouding van 6:1), waardoor ze een levensvatbaardere oplossing zijn voor de opslag van enorme gegevenssets en controlepunten zonder buitensporige kosten.

- Energie-efficiëntie en duurzaamheid. Harde schijven verbruiken 4× minder bedrijfsstroom per terabyte in vergelijking met SSD's, wat leidt tot aanzienlijke energiebesparingen. Ze staan ook voor 10× minder opgenomen koolstof per terabyte, en zijn dus een duurzamere keuze zijn voor grootschalige opslag van AI-controlepunten in datacenters.

- Levensduur. Harde schijven zijn ontworpen om gegevens langdurig te bewaren, zodat controlepuntgegevens zo lang als nodig toegankelijk blijven. Dit is van cruciaal belang om ervoor te zorgen dat AI-modellen na verloop van tijd kunnen worden herzien, geverifieerd en verbeterd.

Zoals we eerder hebben opgemerkt, worden bij sommige AI-werkbelastingen elke minuut controlepunten naar SSD's geschreven, maar wordt alleen elk vijfde controlepunt naar harde schijven gepusht om daar op lange termijn te worden bewaard. Deze hybride aanpak optimaliseert zowel de snelheid als de opslagefficiëntie. SSD's voldoen aan onmiddellijke prestatiebehoeften, terwijl harde schijven de gegevens bewaren die nodig zijn voor regelnaleving, transparantie en langetermijnanalyse.

De rol van controlepunten in betrouwbare AI.

In de bredere context van AI-ontwikkeling is de rol van controlepunten cruciaal om ervoor te zorgen dat AI-outputs legitiem zijn. "Betrouwbare AI" verwijst naar het vermogen om systemen te bouwen die niet alleen accuraat en efficiënt zijn, maar ook transparant, toerekenbaar en verklaarbaar. AI-modellen moeten betrouwbaar zijn en hun output kunnen rechtvaardigen.

Uiteindelijk bieden controlepunten het mechanisme waarmee AI-ontwikkelaars "hun werk kunnen laten zien". Door de toestand van het model op meerdere punten tijdens het trainingsproces op te slaan, houden controlepunten bij hoe beslissingen werden genomen, controleren ze de integriteit van de gegevens en parameters van het model en stellen ze mogelijke problemen of inefficiënties vast die moeten worden gecorrigeerd.

Controlepunten helpen ook vertrouwen op te bouwen door ervoor te zorgen dat AI-systemen kunnen worden gecontroleerd. Regelgevende kaders, zowel de huidige als de toekomstige, eisen dat AI-systemen verklaarbaar zijn en dat hun besluitvormingsprocessen traceerbaar zijn. Met controlepunten kunnen organisaties aan deze vereisten voldoen door gedetailleerde gegevens over het trainingsproces, de gegevensbronnen en de ontwikkelingspaden van het model te bewaren.

Checkpointing is een essentieel hulpmiddel in AI-werkbelastingen en speelt een cruciale rol bij het beschermen van trainingstaken, het optimaliseren van modellen en het garanderen van transparantie en betrouwbaarheid. Nu AI zich blijft ontwikkelen en de besluitvorming in verschillende sectoren blijft beïnvloeden, is de behoefte aan schaalbare en voordelige opslagoplossingen nog nooit zo groot geweest. Harde schijven staan centraal bij de ondersteuning van checkpointingprocessen, en maken het voor organisaties mogelijk om de enorme hoeveelheden gegevens die bij het trainen van AI-modellen worden gegenereerd, te kunnen opslaan, gebruiken en analyseren.

Door gebruik te maken van checkpointing kunnen AI-ontwikkelaars modellen bouwen die niet alleen efficiënt, maar ook betrouwbaar zijn.