Wspólne rozwiązanie Supermicro, Seagate i OSNexus łączy najnowocześniejszy sprzęt i oprogramowanie, zapewniając solidną, skalowalną i wydajną pod względem kosztów infrastrukturę pamięci masowej do obciążeń roboczych związanych z AI. Podstawowe komponenty tego rozwiązania obejmują serwery Supermicro i JBOD, dyski twarde Seagate Mozaic 3+, dyski SSD Seagate Nytro NVMe oraz oprogramowanie OSNexus QuantaStor.

Architektura połączonego rozwiązania obsługuje zarówno konfiguracje skalowalne w górę, jak i w poziomie, zaspokajając różne potrzeby wdrożeniowe.

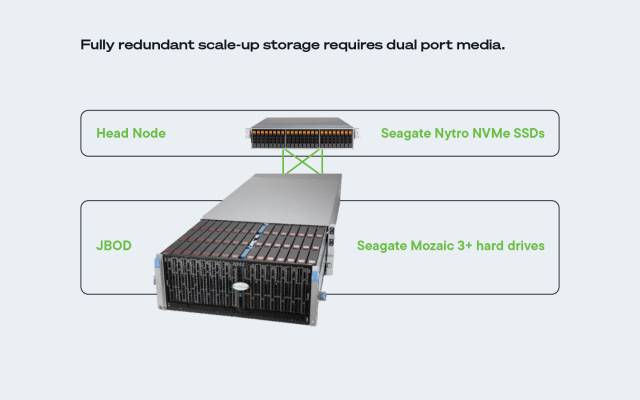

Zmiana skali w górę (lub pionowe) obejmuje zwiększenie pojemności pojedynczego systemu pamięci masowej lub serwera poprzez dodanie większej liczby zasobów, takich jak procesory, pamięć i/lub dyski pamięci masowej. Takie podejście maksymalizuje wydajność indywidualnych jednostek, lecz wiąże się z ograniczeniami w zakresie skalowalności.

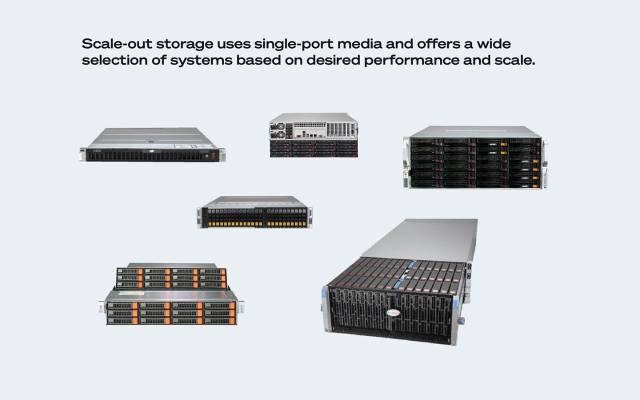

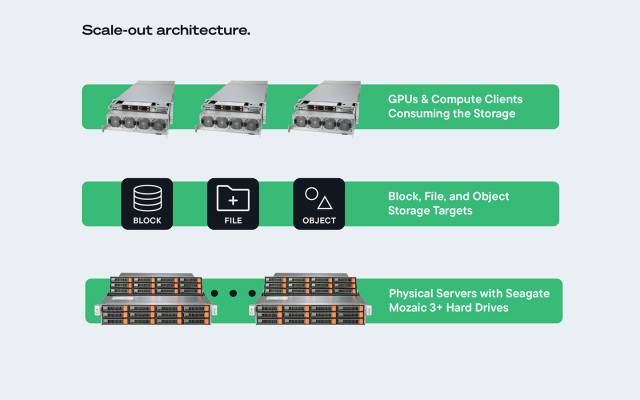

Z drugiej strony skalowanie w poziomie (lub horyzontalne) obejmuje dodawanie do systemu większej liczby węzłów pamięci masowej lub serwerów, co powoduje rozłożenie obciążenia na wiele jednostek. Takie podejście pozwala na praktycznie nieograniczoną skalowalność, umożliwiając systemom obsługę większych, bardziej złożonych obciążeń roboczych AI poprzez płynną rozbudowę architektury w miarę wzrostu zapotrzebowania.

Konfiguracje skalowalne w górę idealnie nadają się do mniejszych, ekonomicznych zastosowań, oferując przepustowość na poziomie 5–10 GB/sekundę. W przeciwieństwie do tego konfiguracje skalowalne w poziomie są przeznaczone do większych wdrożeń i charakteryzują się liniowym skalowaniem wydajności wraz z dołączaniem kolejnych węzłów. Skalowalność tego rozwiązania pozwala osiągać przepustowość rzędu setek gigabajtów na sekundę, co pozwala sprostać wymaganiom intensywnych obciążeń roboczych związanych ze sztuczną inteligencją.

Bezproblemowa integracja serwerów Supermicro, dysków Seagate oraz oprogramowania QuantaStor tworzy spójne i wydajne rozwiązanie pamięci masowej. Architektura ta obsługuje zarówno plikową, jak i obiektową pamięć masową, zapewniając organizacjom elastyczność wyboru konfiguracji najbardziej odpowiedniej dla ich konkretnych potrzeb. Ujednolicone zarządzanie zapewniane przez QuantaStor gwarantuje harmonijną pracę wszystkich komponentów, dostarczając optymalną wydajność i niezawodność. Możliwość zarządzania konfiguracjami skalowalnymi w górę i w poziomie w ramach jednej platformy upraszcza operacje i zmniejsza złożoność związaną z utrzymywaniem wielu systemów pamięci masowej.